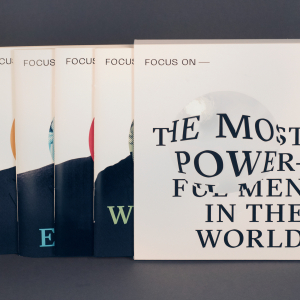

Jahresausstellung der Muthesius Kunsthochschule einblick ausblick

Herzlich Willkommen zu Einblick/Ausblick 2023

Einblick / Ausblick ist ein rauschendes Fest voller Kunst und Gestaltung: Zur Jahresausstellung öffnet die Muthesius Kunsthochschule von Donnerstag, 20., bis Sonntag, 23. Juli, ihre Türen.

An diesen Tagen verwandeln sich Ateliers, Werkstätten, Hörsäle, Studios und Arbeitsräume in eine rund 10.000 Quadratmeter große Ausstellung: Besucher*innen können vier Tage lang bei freiem Eintritt einen Einblick in das künstlerische Schaffen von Studierenden der Freien Kunst, Kunst auf Lehramt an Gymnasien, des Kommunikations- und Industriedesigns sowie der Raumstrategien erhalten.

Einblick / Ausblick steht in diesem Jahr unter dem Motto Vernetzung.

Eröffnung: Donnerstag, 20. Juli, 17 Uhr im Innenhof, Legienstraße 35 in 24103 Kiel

Öffnungszeiten: Alle Räume (die Gallery Cubeplus am Knooper Weg 104, die Räume der Freien Kunst am Knooper Weg 75 neben Boesner und an der Flämischen Straße 6-10) sind im Anschluss an die Eröffnung sowie an den weiteren Ausstellungstagen von Freitag, 21. Juli, bis Sonntag, 23. Juli, täglich geöffnet von 11 bis 19 Uhr.

orte

Altbau, Glasfoyer, Kesselhaus, Vorplatz, Werkstattgebäude

Legienstraße 35, Kiel Einblick in alle Studiengänge

Einblick in alle Studiengänge

Knooper Weg

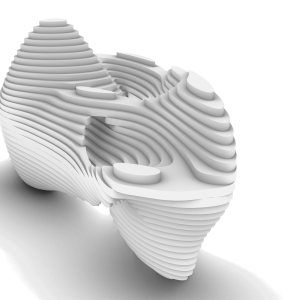

Knooper Weg 75, Kiel Bildhauerei, Grafik, Industriedesign Master, Keramik

Bildhauerei, Grafik, Industriedesign Master, Keramik

Gartenstraße

Gartenstraße 9, Kiel Freie Klasse Film, Interdisziplinäre künstlerische Praxis, Raumstrategien

Freie Klasse Film, Interdisziplinäre künstlerische Praxis, Raumstrategien

Kunstraum B

Wilhelminenstraße 35, Kiel Paola Donato Castillo: „Regresar al Platanal“

Paola Donato Castillo: „Regresar al Platanal“

Materiallabor

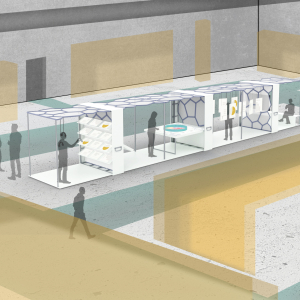

Legienstraße 27, Kiel Industriedesign und Raumstrategien: „Rethinking Bricks“

Industriedesign und Raumstrategien: „Rethinking Bricks“

Gallery Cubeplus

Knooper Weg 104, Kiel Interdisziplinäre Klasse: „Flesh in Form“

Interdisziplinäre Klasse: „Flesh in Form“

Alte Mu

Lorentzendamm 6–8, Kiel Gruppenausstellung: „zusammen-tragen“

Gruppenausstellung: „zusammen-tragen“

Natia Benashvili: „Erinnerst du dich an mich?“

Natia Benashvili: „Erinnerst du dich an mich?“

Flämische Straße

Flämische Straße 6, Kiel Interdisziplinäre Klasse: „in Media res“

Interdisziplinäre Klasse: „in Media res“

spce | Muthesius

Andreas-Gayk-Straße 7–11, Kiel Interdisziplinäre Installation: „Future Night Train“

Interdisziplinäre Installation: „Future Night Train“

Fabrikstraße

Fabrikstraße 10, Kiel Malerei: „A Glimpse into Parallel Worlds“

Malerei: „A Glimpse into Parallel Worlds“

Kunstverein Haus 8, Atelierhaus im Anscharpark

Heiligendammer Straße 15, Kiel Medienklasse Master: „Toast in der Ferne“

Medienklasse Master: „Toast in der Ferne“

Mfg5-Gelände

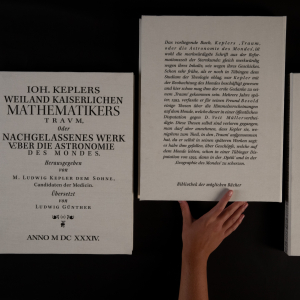

Schusterkrug 25, Kiel/Holtenau Interaktives Informationsdesign Master: „Evolution – Exponate zur Wissenschaftskommunikation“

Interaktives Informationsdesign Master: „Evolution – Exponate zur Wissenschaftskommunikation“

awareness

Bei Einblick / Ausblick sollen sich alle sicher und wohl fühlen.

Wir verstehen unter awareness einen achtsamen und respektvollen Umgang mit den individuellen Grenzen und Bedürfnissen aller Personen. Sowie einen respektvollen Umgang mit unseren Aus- stellungsstücken. Jegliche Arten von Diskriminierung, Übergriffen und Gewalt werden nicht geduldet.

Ihr erkennt unser awareness- Team an den gelben Bändern. An unserem E / A-Stand ist immer eine Ansprechperson zu finden. Sprecht uns gerne jederzeit an! :)

Die Muthesius Kunsthochschule Kiel

2005 als erste und einzige Kunsthochschule Schleswig-Holsteins gegründet, blickt die Muthesius Kunsthochschule auf eine mehr als 100-jährige bewegte Geschichte zurück. Als Teil der Kieler Gewerbeschule mit kunstgewerblicher Ausrichtung 1907 gegründet, wurde sie 1972 Teil der Fachhochschule Kiel, später selbständige Fachhochschule für Kunst und Gestaltung.

Die Muthesius Kunsthochschule bietet die Studiengänge Freie Kunst, Kunst Lehramt an Gymnasien, Raumstrategien, Industrie- und Kommunikationsdesign an. Seit 2007 verfügt die Kunsthochschule über das Promotionsrecht. Heute sind mehr als 650 Studierende in den Bereichen Kunst und Design eingeschrieben; sie kommen aus mehr als 30 Ländern.